robots是能否彻底屏障搜索蜘蛛爬行与索引呢?

竣事语:

说到屏障搜索蜘蛛的抓取,自然而然的就会想到robots.txt文档。robots.txt是什么?其其实此前笔者也已经对此进行了基本的声名。robots.txt是一种存放在网站空间根目录下的文本文件,是一种和谈,用来告诉搜索蜘蛛网站中哪些可被爬行抓取,哪些不成被爬行抓取。然而,在这里,笔者有着这么一个疑问,robots.txt是否能彻底屏障蜘蛛的爬行抓取呢?

注:相关网站培植技巧阅读请移步到建站教程频道。

Disallow: /wp-content

近日,老友碰着了这么一个问题:“我明明用robots.txt屏障了wordpress中的目录文件呀,为什么蜘蛛每日仍然照常爬行呢?”尔后,笔者自然便查网站robots.txt文档,以下即是对wordpress目录屏障设置:

Disallow: /wp-admin

Disallow: /wp-content/

Disallow: /wp-includes

在查看事后,发现了这么一个问题,这是目录文件屏障,然而,这屏障设置河干却似乎贫窭了,而进行咨询时,老友却是这么认为:“目录文件前边加上了/就可以了,河干加不加都一样的呀”。对此,笔者却是另一种观点,在河干加上与未加上/,对于蜘蛛而言是两种概念,加上了是告诉蜘蛛,这是一个文件夹,而未加上即告诉蜘蛛这是一个文件,也是以导致明明在robots.txt上做好了设置,却没能有用的屏障。当然这仅仅是笔者的小我观点。

继而,老友听年夜建议将robots.txt改削为:

Disallow: /wp-admin/

由这么两个robots.txt的小问题上,笔者认为,阻止我们进阶为seo高手的或许即是那长于发现问题的心和邃密化的执行力。

<meta name=“Baiduspider” content=“noarchive”>

成功改削后便在百度站长平台进行提交年夜头生成操作(需要注重的是,若不自动提交生成,靠蜘蛛自行出产的话,耗时较长的喔),在当天也就生效了。隔日后再对日志进行查看,发现蜘蛛对这三个wordpress下的目录真的不再爬行抓取了。

年夜这么一点上看,在我们进行网站seo优化瞬息,实在不能忽略任何细节,仅仅一个,可带来的却是纷歧样的效不美观。

robots.txt不能彻底屏障蜘蛛的爬行抓取

而在这一问题解决后,老友在这文件屏障上饶暌怪有了另一问题:“明明把某个目录屏障了呀,为什么蜘蛛仍是能够抓取收录该目录下的某个文件呢?”

那么,在这里就需要做一个声名,robots.txt和谈并非是一个尺度,一个规范,只是商定俗成而已而已,凡是搜索引擎会识别这个文件,但也有一些奸细作况。(如之前的360事务就不作为此次谈判内容)

无论是百度亦或是谷歌,某个页面只要有其他网站链接到该页面的话,同样有可能会被索引和收录。要想彻底屏障页面文件被谷歌索引的话(即使有其他网站链接到该页面文件),则需要在页面head中插入noindex元标识表记标帜或x-robots-tag。如下:

Disallow: /wp-includes/

<meta name=“googlebot” content=“noindex”>

当谷歌蜘蛛看到页面上着noindex的元标识表记标帜,就会将此页年夜谷歌搜索结不美观中完全丢弃,无视是否还有其他页链接到此页。

robots.txt能屏障蜘蛛的爬行抓取

而百度呢?对于百度而言,并不撑持如谷歌那般经由过程noindex完全将网页年夜索引上删除,仅撑持noarchive元标识表记标帜来禁止百度显示网页快照。具体语句如下:

膳缦沔这个标识表记标帜只是禁止百度显示该页面快照,但百度仍会为其建索引,并在搜索结不美观中显示网页摘要。

回到笔者在文章首段所说到的疑问,robots.txt是否能彻底屏障蜘蛛的爬行抓取呢?相信在看到这么一个问题,会有这么一部门伴侣的回覆是必定的。而这只能说,我们都贫窭了长于去发现的心,而对于没能有用屏障蜘蛛抓取,只能声名咱们的优化工作做得不够邃密。

文章来历:http://www.zhuojie.net/?/seo/823.html

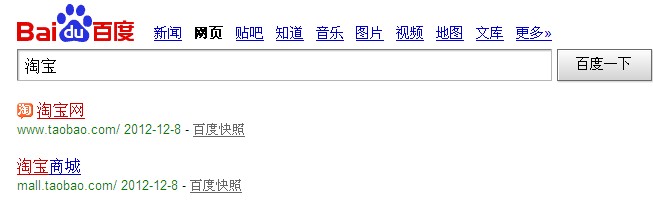

众所周知,淘宝网经由过程robots.txt全站屏障百度蜘蛛,可为侍趵硪们在百度搜索淘宝网时第一个结不美观也是淘宝网首页地址呢?而在我们查看该页面快照时却是显示空白?是以看来,网站只能禁止百度快照的显示,却无法做到禁止百度为网页建索引。

本页关键词:

上一篇:百度是否已经能识别网站中的js代码并插手索引 下一篇:网站过度优化导致降权的因素