关于robots的写法网上有良多的介绍,Robots可以用来防止搜索引擎抓取那些我们不想被搜索引擎索引的内容,良多网站都在琅缦沔插手网站的地图sitemap.xml,这样可以让蜘蛛快速的爬行网站。

名目:

Sitemap:sitemap.xml

我们来看看一些年夜型网站的robots.txt是怎么样写的!

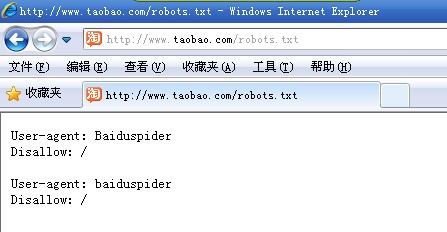

淘宝的robots.txt,屏障了百度蜘蛛

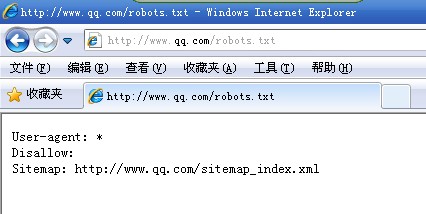

QQ在robots中插手了sitemap

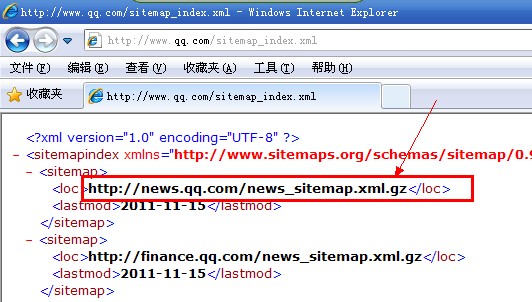

打开qq的sitemap之后发现,存在这样的压缩包,下载回来打开琅缦沔放的是sitemap,莫非蜘蛛可以剖析压缩包了?像我仍是头一次见到这样的写法。

User-agent: *

Disallow:

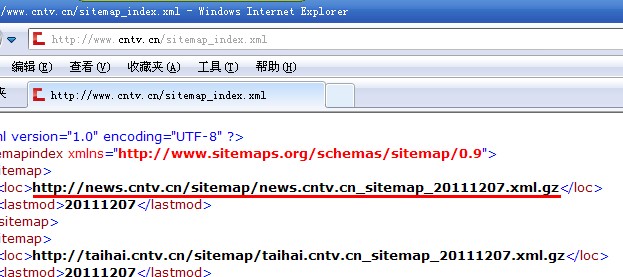

CCTV也同样是这样的写法

在robots.txt中插手sitemap这样做到底能不能增添收录,站长伴侣们不妨试试!最后感谢感动瓜视云点播www.tvgua.com站长供给配图!

粤公网安备44010502000280号

粤公网安备44010502000280号 公众号二维码

公众号二维码

小程序二维码

小程序二维码