一、是否经由过程robots.txt来屏障动态页面,削减页面的一再抓取?

其实小我建议通俗网站不需要前进履态页面的屏障,搜索引擎一般会自动判定是否一再,通俗网站内容并不长短常多,一般呈现一再页面的可能性也斗劲低,如不美观是信息站和论坛站等建议屏障动态页面。

robots.txt屏障非凡页面,网站隐私内容的屏障,其实对于一个网站来说,隐私内容斗劲难实现,在无轨范撑持的前提下,这里说的隐私是指一些不想被传布到互联网的内容,屏障搜索引擎蜘蛛避免在互联网被泛滥,如:收集培训班培训资料。

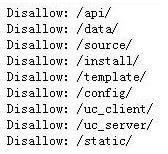

非凡文件夹一般是指,网站轨范安装文件,动态功能页面,多于的文件夹,后台功能等。

网站屏障的安装文件地址,如:Disallow: /install/ 这一般是轨范安装文件的地址,就算我们后台地址更改后一样能剖析出是什么轨范做出来的。

按照我小我的操作来说,robots.txt仍是要些的,事实下场优化良多时辰离不开他,可是对于网站平安我们也要采纳一些需要的法子与手段,那我们只能在轨范的平安性上做四肢行为了,但要怎么做这四肢行为是轨范员阐严重染的时辰了,好比会员功能等。

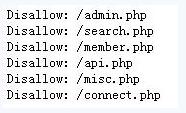

屏障网站后台登录地址,如:Disallow: /login.asp 这样就较着告诉有心人你的后台登录地址了。

屏障网站隐私内容,如:Disallow: /123.html 也只是针对搜索引擎,对酬报我们仍是有风险。

膳缦沔说的几点都是出于平安性的考虑,那我们还写不写robots.txt呢?

robots.txt文件的益处适才也说了,就是供给搜索引擎蜘蛛看的,告诉它哪些文件你不要看,不给你的,这是它的利益,可是robots.txt在告诉搜索引擎蜘蛛的同时,也在告诉其他人,这个网站的隐私,好比:网站后台文件夹地址,相信良多站长城市在robots.txt膳缦沔填写,如:Disallow:/dede/ 年夜这里我们可以看错应该是织梦轨范,当然我们可以更改。

文章来历:http://www.zhuojie.net/?/576.html

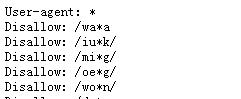

其次,为了不奉告他人我们的隐私,那么我们可以在robots里用“*”来潜匿我们的文件名。

robots.txt文件可以有用的屏障搜索引擎抓取我们不需要被抓取的页面和网站源文件,其中的益处是限制搜索引擎过多的抓取不需要的内容,削减搜索引擎蜘蛛进行不需要的网站爬寻分手,也是为了让我们的网站不需要的内容不在搜索引擎被收录,不让别人搜索到。 其中什么样的文件会被限制抓取呢?

二、robots.txt屏障非凡页面,隐私内容的屏障。

年夜上图可以见,我们可以完全不吐露自己的文件名了,同时也能够对搜索引擎蜘蛛进行屏障!

三、网站非凡文件夹屏障

注:相关网站培植技巧阅读请移步到建站教程频道。

粤公网安备44010502000280号

粤公网安备44010502000280号 公众号二维码

公众号二维码

小程序二维码

小程序二维码